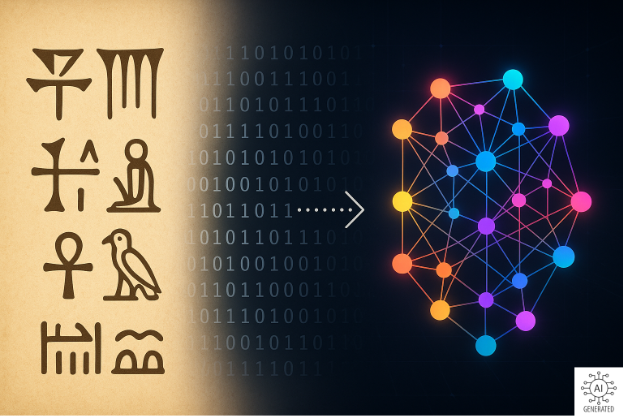

Dai Simboli ai Modelli di Linguaggio

Dall'Intelligenza Simbolica ai Modelli di Linguaggio: Un Viaggio nel Cuore dell'IA

Nell’articolo precedente abbiamo esplorato come l'intelligenza non sia un privilegio esclusivo dell'essere umano, ma una capacità di agire efficacemente in situazioni nuove, manifestandosi in una miriade di forme "aliene" su questo pianeta. Oggi, ci immergiamo nel percorso affascinante e spesso sorprendente che ha portato l'Intelligenza Artificiale (IA) a emulare e persino superare alcune delle nostre capacità, abbandonando l'idea di dover "pensare come noi" per abbracciare un approccio completamente nuovo: quello dei dati.

Il Sogno Iniziale: Ragionare come un Umano

Agli albori dell'Intelligenza Artificiale, i pionieri si prefissero un obiettivo ambizioso: creare macchine capaci di ragionare formalmente, manipolando simboli proprio come farebbe un logico umano. Nacquero così programmi come il Logic Theorist, in grado di dimostrare teoremi, e il General Problem Solver, presentato come una forma di "intelligenza generale" basata sulla capacità di procedere da assiomi a teoremi. Il messaggio era chiaro: dietro ogni espressione di intelligenza doveva esserci lo stesso ingrediente elusivo, la capacità di ragionare sui simboli.

Questo approccio si concretizzò negli anni '80 con i cosiddetti "Sistemi Esperti" o "Intelligenza Artificiale simbolica". L'idea era di codificare esplicitamente le conoscenze specialistiche umane sotto forma di regole logiche, permettendo alle macchine di usarle per prendere decisioni in campi specifici come la medicina o la chimica. L'informatico Ed Feigenbaum, considerato il “padre dei sistemi esperti”, sosteneva che le macchine intelligenti necessitassero di una grande quantità di conoscenze "scritte in forma dichiarativa" per operare nel mondo reale.

Le Sfide del Mondo Reale: Troppe Regole, Troppa Ambiguità

Tuttavia, questo approccio si scontrò presto con una realtà complessa e ambigua. Si scoprì che fenomeni apparentemente semplici come la visione o la comprensione del linguaggio richiedevano un numero spropositato di regole esplicite, che non erano "mai abbastanza". Il mondo reale si rivelò troppo incerto e ambiguo per essere interamente descritto da regole predefinite e, di conseguenza, i Sistemi Esperti divennero troppo delicati e costosi da mantenere. Non era facile per i programmatori enumerare in anticipo tutti i possibili input e i loro corrispondenti output. Si doveva trovare un modo diverso.

La Rivoluzione dei Dati: Dall'Intelligenza Simbolica all'Apprendimento Automatico

La lezione degli anni '90, plasmata dalle sfide del Web, portò a un cambio di paradigma radicale: invece di cercare di codificare ogni regola, i ricercatori iniziarono a studiare come generare comportamenti intelligenti perseguendo uno scopo e sfruttando relazioni statistiche nell'ambiente. L'obiettivo non era più scoprire "qualche verità", ma generare un comportamento "probabilmente approssimativamente corretto". Nacque così il machine learning (apprendimento automatico), che divenne la disciplina centrale del campo dell'IA, dove i dati di addestramento divennero la risorsa più preziosa e la misurazione delle prestazioni un'ossessione. La nuova scienza delle macchine intelligenti iniziò a parlare il linguaggio della probabilità e dell'ottimizzazione matematica, non più quello della logica formale. Frederick Jelinek, un informatico dell'IBM estremamente attivo nel campo del Linguaggio Naturale, sintetizzò questo cambiamento con una frase provocatoria: "Tutte le volte che licenzio un linguista la performance del nostro sistema migliora".

Questo cambio di rotta significava che le macchine avrebbero dovuto imparare dalle loro esperienze, trovando ordine e regolarità nel mondo, anche deboli regolarità statistiche, per comportarsi in modo efficace.

L'Ascesa dei Modelli di Linguaggio (LLM): Un Nuovo Modo di "Comprendere" il Mondo

La vera svolta arrivò con una specifica architettura di rete neurale chiamata "Transformer". Implementata su scala immensa, questa tecnologia è oggi alla base dei modelli di linguaggio come GPT (Generative Pre-trained Transformer). Questi modelli sono addestrati a risolvere un problema all'apparenza semplice ma in realtà profondissimo: predire le parole mancanti in un testo. Esercitandosi su "quantità immense di testo" – miliardi di parole tratte da libri e pagine web – l'algoritmo non solo apprende il linguaggio, ma anche "il mondo".

Il risultato di questo processo è quello che Nello Cristianini chiama un "modello del mondo". Questo modello non si limita a rappresentare dati, ma idee e conoscenze, comprese le relazioni tra queste idee, creando una vera e propria "visione del mondo".

La cosa più sorprendente è che da questo addestramento emergono spontaneamente capacità impreviste. Modelli linguistici come GPT hanno dimostrato di saper fare aritmetica, giocare a scacchi, programmare e persino comprendere la giurisprudenza, senza che queste abilità fossero state esplicitamente programmate. I ricercatori stessi sono rimasti "sorpresi" da quante "abilità inaspettate" emergessero semplicemente aumentando le dimensioni del modello e la quantità di dati. Come ha osservato Geoffrey Hinton, il “padrino dell’AI”, premio Nobel per la Fisica nel 2024 grazie al suo lavoro dirompente con le reti neurali, è "come se fossero atterrati gli alieni, ma la gente non lo avesse capito, perché parlano un buon inglese".

L'Ipotesi della Scala: Più Grande È Meglio?

Una delle forze trainanti dietro il successo di questi modelli è la cosiddetta "Ipotesi della Scala" (Scaling Hypothesis). Questa congettura suggerisce che alcune proprietà cognitive dei modelli di IA emergono solo quando le loro dimensioni superano un certo ordine di grandezza. In altre parole, aumentare la scala dei modelli e la quantità di dati non solo migliora le prestazioni in compiti già noti, ma può sbloccare abilità completamente nuove. Il progresso esponenziale nella potenza di calcolo, come previsto dalla Legge di Moore, ha permesso di costruire reti neurali con miliardi di parametri, passando dai 60 mila di LeNet negli anni '90 ai 1.000 miliardi di GPT-4.

Questo ha portato l'industria a scommettere che semplicemente continuando ad aumentare la scala si possano risolvere molti problemi, soprattutto quelli che non richiedono un ragionamento esplicito, definiti di "Sistema 1" dal premio Nobel Daniel Kahneman. Le aziende investono enormemente in dati, hardware ed energia per creare modelli sempre più grandi.

Un Futuro Sconosciuto ma Pieno di Promesse (e Incognite)

Oggi, siamo di fronte a macchine come ChatGPT, lanciato nel 2022, che hanno rapidamente raggiunto oltre 100 milioni di utenti, dimostrando capacità di conversazione, collegamento di informazioni e ragionamento che stupiscono anche i loro creatori. Non si tratta più solo di emulare la logica umana, ma di distillare la conoscenza da un'immensa quantità di informazioni per sviluppare una "comprensione del mondo" unica e potente.

Questo ci porta a riflettere su cosa queste macchine "sappiano" di noi e del mondo, e come potremmo controllare entità che potrebbero superare la nostra comprensione. La storia dell'IA è un viaggio costante di ridefinizione e scoperta, un cammino che continua a svelare nuove "intelligenze aliene" e a porci domande fondamentali sul nostro stesso posto nell'universo del pensiero.